Les analystes d'IDC prévoient une multiplication par dix des données mondiales d'ici 2025 pour atteindre 163 zetabytes (163 millions d'exabytes). Environ 60% de ces données sont générées par les entreprises. Alors qu'au cours de la dernière décennie, l'accent était mis sur la conversion des données analogiques en données numériques, l'industrie se concentre désormais de plus en plus sur la valeur ajoutée de ces données.

Le fait que l'entreprise d'études de marché Gartner n'identifie toutefois aucun leader du marché dans son actuel Magic Quadrant, mais seulement des innovateurs (PTC, Hitachi, SAP) et divers fournisseurs de niche, montre le potentiel pour les fabricants et les coopérations entre fabricants. De leur côté, les entreprises doivent aujourd'hui procéder à une analyse précise de l'existant et des besoins et rechercher des solutions qui leur apportent déjà une valeur ajoutée dans certains domaines d'application. L'utilisation d'applications de test et de mesure intelligentes est donc un domaine d'application important pour de nombreuses applications IIoT.

Défis pour les applications de test et de mesure

L'objectif général est d'augmenter l'efficacité opérationnelle, de mettre en œuvre des techniques de production flexibles et d'optimiser les processus de collecte et de traitement des données. Dans de nombreux domaines d'application, les capteurs et les données de capteurs qui fournissent la base de données pour l'automatisation et les machines auto-apprenantes jouent un rôle central. La maintenance prédictive est également un thème important dans ce domaine. Les structures et les systèmes des applications de test et de mesure changent toutefois rapidement, les systèmes de collecte de données correspondants doivent pouvoir suivre ces évolutions pour ne pas se révéler être une impasse en matière d'investissement.

En même temps, il n'y a pas d'IIoT sans analytique. Pour pouvoir travailler plus rapidement et plus efficacement, les données doivent être surveillées en temps réel, ce qui peut rapidement conduire à une collecte de données d'une ampleur gigantesque, qui ne peut plus guère être traitée efficacement ou même transférée et stockée de manière économique sur un serveur distant. Le défi ne consiste donc pas seulement à collecter les données, mais aussi à réduire judicieusement les données brutes sur leur lieu de création afin de ne transmettre que les informations pertinentes et de limiter ainsi le volume des données. Le traitement des données doit également répondre aux exigences élevées en matière de performance, d'évolutivité et de sécurité. L'augmentation de l'efficacité du traitement passe donc aussi par des mesures d'indexation, de regroupement des données, comme par exemple l'étiquetage automatisé (métadonnées, classification des ensembles de données) ou la réduction statistique des données (moyenne, écart-type, minimum, maximum).

Collaboration IIoT dans l'environnement des capteurs

Alors que les acteurs mondiaux luttent encore pour trouver des solutions réalisables, les entreprises établies Gantner Instruments GmbH et Althen GmbH Mess- und Sensortechnik de Kelkheim présentent déjà des solutions IIoT concrètes pour les techniques de mesure et de contrôle industrielles.

En tant que spécialiste des systèmes de mesure et d'E/S décentralisés ainsi que de la mesure de grandeurs mécaniques, thermiques et électriques, Gantner Instruments apporte ses solutions d'acquisition de données et de connectivité ainsi que la configuration à distance et le logiciel d'évaluation. Althen intègre ses capteurs de haute qualité dans les systèmes complets et se charge des préréglages spécifiques des plages de mesure, du réglage des paramètres d'ajustage pour les capteurs calibrés ainsi que des éventuels calculs mathématiques et réglages d'alarme en fonction des exigences du client. Il en résulte de multiples possibilités d'application, par exemple la surveillance de la fatigue des matériaux dans les centrales nucléaires et les installations de fusion nucléaire, le contrôle de la qualité du réseau ferroviaire dans les transports publics locaux, la mesure de l'allongement sur les systèmes de pipelines flexibles, la maintenance prédictive des machines, des installations ou encore dans les appareils mobiles, par exemple dans les machines de construction et les chemins de fer.

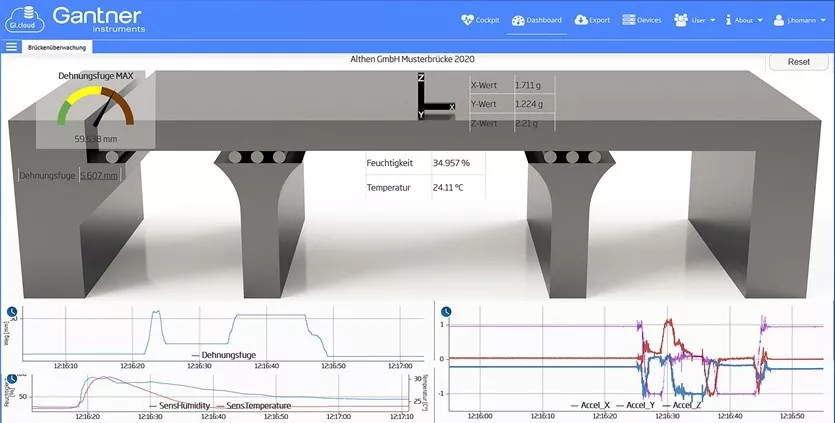

Surveillance à distance d'un pont

Il vaut la peine de se pencher sur un exemple concret, ici la surveillance d'un pont. Avec une topologie similaire, on pourrait toutefois envisager d'autres surveillances dans le domaine des infrastructures, par exemple pour les ponts ferroviaires, routiers et autoroutiers, les bâtiments importants, les barrages, les digues ou les installations industrielles (raffineries, chimie, éoliennes, etc.).

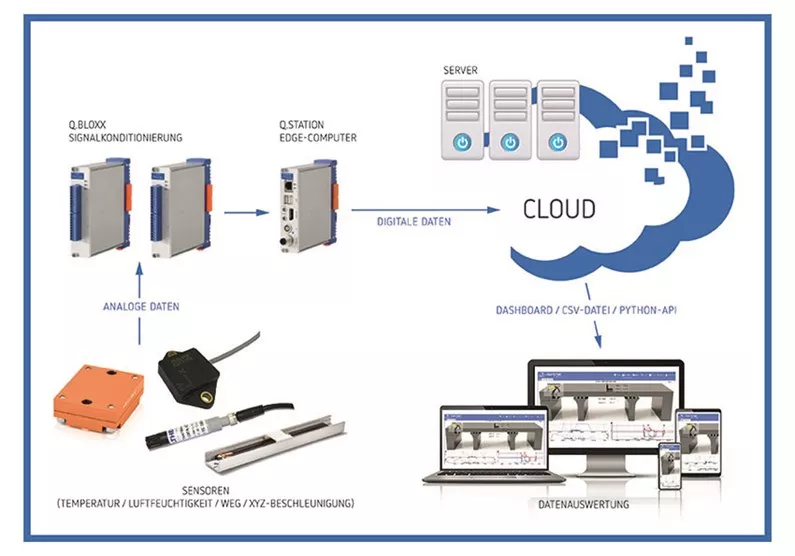

Le système utilisé est le Q.series X de Gantner, un système de mesure décentralisé et très flexible de construction modulaire, qui convient également pour un montage sur rail DIN. Cette forme de construction typique d'un système de mesure décentralisé offre un maximum de flexibilité et d'interfaces. La composition à volonté des modules d'acquisition de données permet une adaptation optimale à la tâche à accomplir et convient parfaitement aux applications décentralisées.

Concrètement, des modules de la Q.series X sont utilisés pour la connexion des capteurs (Q.bloxx-XL A108, Q.bloxx-XL A101) et le contrôleur (Q.station-XB) pour la connexion et la manipulation des modules ainsi que pour les calculs et la transmission vers le cloud.

Dans l'exemple actuel, le système est complété par l'accéléromètre triaxial ASC 5511LN d'Althen, qui est connecté aux modules Q.series X. En plus de l'accélération, la température, l'humidité de l'air (représentant l'humidité du matériau de construction dans le pont) et un potentiomètre (représentant une mesure de déplacement du joint de dilatation du pont) sont surveillés.

Données IIoT dans le résultat

Le système complet IIoT permet une surveillance à distance confortable en temps quasi réel. L'analyse des données sur une longue période permet de détecter les modifications de la structure ainsi que la fatigue des matériaux. De même, il est possible de tirer des conclusions sur d'éventuels défauts et donc sur la durée de fonctionnement restante d'un pont. Les capteurs Althen sont actuellement lus à trois vitesses différentes. Ils fournissent des données au cloud via l'infrastructure de Gantner, avec une fréquence de mesure de 10 Hz, 1 kHz, 10 kHz.

Collecte efficace des données et évaluation préalable

Des tests ont déjà été réalisés avec la vitesse de mesure la plus élevée possible de 100 kHz. Ces vitesses de mesure ne sont toutefois pas absolument nécessaires dans la réalité à l'heure actuelle et augmenteraient inutilement les exigences en matière de bande passante et de capacités de serveur. Mais elles montrent en même temps la pérennité de la plateforme en termes de performance et d'évolutivité.

Une limitation et une évaluation préalable sont également judicieuses pour la configuration existante, car il suffit de quelques capteurs pour que les données brutes produisent de grandes quantités de données. Par exemple, un capteur qui mesurerait des vibrations à 1 000 kHz 24 heures sur 24 produirait environ 345 Go par jour et 126 To par an. Si l'on se réfère à l'exemple d'application avec 15 valeurs de mesure, cela correspondrait à 1 892 TB de données brutes par an.

En conséquence, une évaluation préalable sur la base d'algorithmes est effectuée, après une configuration correspondante, déjà dans le contrôleur sur place (EDGE Computing), mais aussi dans le cloud, afin de réduire le volume de données en conséquence. Le transfert des données du cloud vers des programmes d'analyse externes est également possible, aussi bien via le format classique CSV que via une interface API complète et intégrable. Même les anciens jeux de données déjà disponibles peuvent être entièrement intégrés dans les nouveaux jeux de données actuels via un téléchargement CSV, traités et visualisés dans la même interface.

Collecte efficace des données et évaluation préalable

Des tests ont déjà été réalisés avec la vitesse de mesure la plus élevée possible de 100 kHz. Ces vitesses de mesure ne sont toutefois pas absolument nécessaires dans la réalité à l'heure actuelle et augmenteraient inutilement les exigences en matière de bande passante et de capacités de serveur. Mais elles montrent en même temps la pérennité de la plateforme en termes de performance et d'évolutivité.

Une limitation et une évaluation préalable sont également judicieuses pour la configuration existante, car il suffit de quelques capteurs pour que les données brutes produisent de grandes quantités de données. Par exemple, un capteur qui mesurerait des vibrations à 1 000 kHz 24 heures sur 24 produirait environ 345 Go par jour et 126 To par an. Si l'on se réfère à l'exemple d'application avec 15 valeurs de mesure, cela correspondrait à 1 892 TB de données brutes par an.

En conséquence, une évaluation préalable sur la base d'algorithmes est effectuée, après une configuration correspondante, déjà dans le contrôleur sur place (EDGE Computing), mais aussi dans le cloud, afin de réduire le volume de données en conséquence. Le transfert des données du cloud vers des programmes d'analyse externes est également possible, aussi bien via le format classique CSV que via une interface API complète et intégrable. Même les anciens jeux de données déjà disponibles peuvent être entièrement intégrés dans les nouveaux jeux de données actuels via un téléchargement CSV, traités et visualisés dans la même interface.